Fundamentos Cognitivos

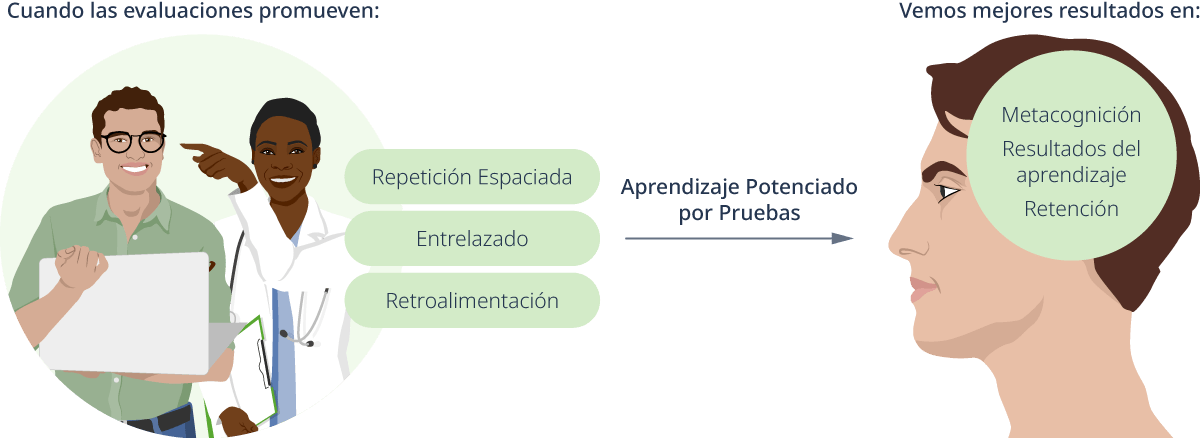

En lugar de utilizar las evaluaciones para determinar si se ha producido el aprendizaje, también pueden utilizarse para apoyar el aprendizaje. El aprendizaje potenciado por pruebas (TEL, por sus siglas en inglés) es un enfoque que utiliza las evaluaciones para mejorar el recuerdo y la retención del aprendizaje. Una revisión del BEME sobre el aprendizaje potenciado por pruebas en las profesiones médicas descubrió que el uso de la evaluación para apoyar el aprendizaje era muy efectivo para varios alumnos y tipos de evaluación (2). Se ha demostrado que el uso de evaluaciones cortas y espaciadas para apoyar la práctica de la recuperación mejora la capacidad del alumno para recordar la información posteriormente. En otras palabras, el uso de evaluaciones que fomentan el recuerdo con esfuerzo aumenta la retención y la transferencia del aprendizaje. Las evaluaciones más específicas que fomentan el recuerdo con esfuerzo, como las preguntas de opción múltiple (MCQ, por sus siglas en inglés) ricas en contexto, las preguntas de respuesta corta, los ensayos y los pacientes estandarizados, fomentan un aprendizaje más efectivo que los estudiantes que utilizan prácticas de estudio menos efectivas, como la relectura.

El uso de evaluaciones cortas y espaciadas promueve la práctica de recuperación. Se ha demostrado que la práctica de recuperación mejora la capacidad del alumno para recordar la información posteriormente. Además, se ha demostrado que el recuerdo esforzado aumenta la retención y la transferencia del aprendizaje. Las evaluaciones espaciadas que promueven el recuerdo esforzado, como las preguntas de opción múltiple frecuentes y ricas en contexto, las preguntas de respuesta corta y las respuestas abiertas, fomentan un aprendizaje más efectivo que un solo examen o prácticas de estudio menos efectivas, como la relectura.

El uso tradicional de las evaluaciones sumativas, que evalúan el aprendizaje al final de la instrucción, determina si se ha producido el aprendizaje, pero hace poco para proporcionar retroalimentación correctiva o apoyar el aprendizaje. En cambio, las evaluaciones frecuentes de baja exigencia, a menudo denominadas evaluaciones formativas, pueden utilizarse para reforzar las habilidades y fomentar la repetición espaciada y el entrelazado. Los estudios han demostrado que la estructuración de los cuestionarios a lo largo del curso para utilizar la repetición espaciada y el entrelazado puede mejorar la metacognición y la retención de conocimientos en comparación con los cuestionarios tradicionalmente estructurados (3). Cuando se realizan evaluaciones formativas, la retroalimentación es una parte esencial del enfoque de aprendizaje potenciado por pruebas y se recomienda, como mínimo, dar las respuestas correctas y la justificación (2,4). La retroalimentación apoya el aprendizaje corrigiendo los conceptos erróneos y reforzando las respuestas y el razonamiento correctos.

El aprendizaje potenciado por pruebas utiliza conceptos como la repetición espaciada, el entrelazado y la retroalimentación adecuada para mejorar la metacognición, los resultados del aprendizaje y la retención.

Diseño de Evaluaciones

Las evaluaciones mal diseñadas no sirven para medir el aprendizaje de los estudiantes y a menudo frustran tanto a los estudiantes como al profesorado. Las evaluaciones bien diseñadas deben apoyar el proceso de aprendizaje y ayudar a tomar decisiones como la de determinar la finalización de los estudios, la obtención de la licencia o la necesidad de remediación.

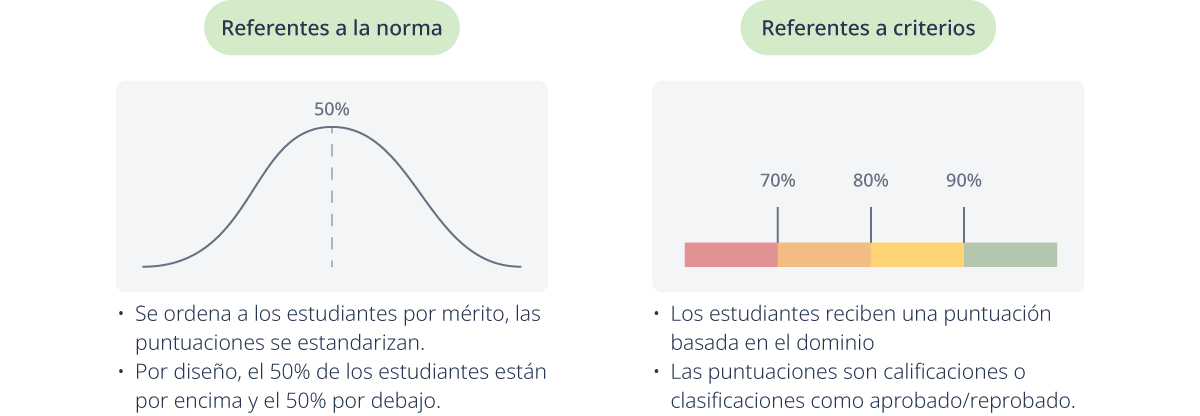

Las evaluaciones pueden dividirse en dos grandes categorías: referentes a la norma y referentes a criterios. Las pruebas referentes a la norma dan una clasificación o ubicación comparando a los estudiantes con un grupo de estudiantes representativos llamado muestra normativa (5). Estos tipos de pruebas proporcionan un rango percentil y puntuaciones estandarizadas, como las que se obtienen en el Scholastic Aptitude Test (SAT), el Medical College Admission Test (MCAT) o las pruebas de inteligencia (IQ). Las pruebas referentes a criterios califican a los estudiantes en función de su competencia o dominio de un conjunto de habilidades (5). Se basan en un conjunto predeterminado de criterios y dan lugar a una calificación percentil o una determinación de aprobado/reprobado. Las pruebas referentes a criterios son las más utilizadas en el salón de clase y también pueden incluir pruebas para la obtención de licencias, como el United States Medical Licensing Examination (USMLE) y el National Council Licensure Examination (NCLEX) en Estados Unidos o el examen «International Foundations of Medicine» (IFOM). Muchos países tienen sus propias versiones de estos exámenes de licencia. Este artículo se centrará en las evaluaciones referentes a criterios, ya que son las más utilizadas en los salones de clase.

Las evaluaciones referentes a la norma y a criterios son dos grandes categorías de evaluaciones.

Planificación de Evaluaciones

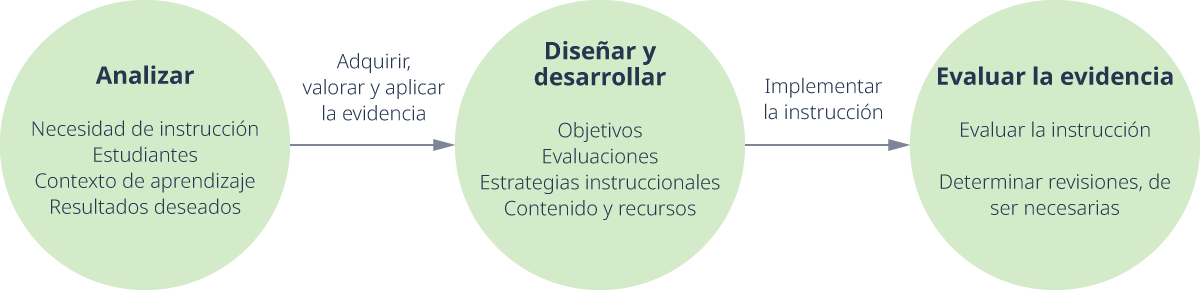

Recordando los principios del diseño instruccional, las evaluaciones deben ser un componente planificado del diseño del curso, alineado con los objetivos y el contenido. El diseño del curso comienza con la determinación de la necesidad de instrucción y el análisis tanto de los alumnos como del contexto de aprendizaje. A partir de aquí, el diseñador de la instrucción y/o el miembro de la facultad adquiere y evalúa la evidencia educativa disponible relacionada con las necesidades de instrucción identificadas. Esta fase informa el desarrollo de los objetivos, que a su vez impulsa la determinación de las evaluaciones, la estrategia de instrucción y el contenido. Una vez implementada la instrucción, los resultados se valoran evaluando la instrucción y determinando la necesidad de revisiones.

Planificar las evaluaciones como parte del proceso de diseño instruccional

La necesidad de instrucción, los alumnos, el contexto de aprendizaje y los objetivos ayudan a determinar la necesidad de evaluación, por ejemplo:

- El formato en el que se evaluará a los alumnos, por ejemplo, en línea, en papel u observación en un entorno clínico.

- El número de evaluaciones que se realizará y cuándo.

- El tipo de retroalimentación necesaria para ayudar a los estudiantes a desarrollar las habilidades, conocimientos y disposiciones.

Una vez establecidos, las evaluaciones pueden ajustarse a los objetivos en función del dominio de aprendizaje y el nivel de rendimiento deseado (por ejemplo, la taxonomía revisada de Bloom).

Alineación de Evaluaciones

En nuestro artículo anterior, abordamos la alineación de los objetivos de aprendizaje con la evaluación y la instrucción, especialmente con respecto a los dominios de aprendizaje y los verbos de acción utilizados en los objetivos. Por ejemplo, un objetivo que implique el dominio afectivo, como «Los estudiantes serán capaces de comunicarse de forma clara y compasiva con las familias de los pacientes pediátricos» se evaluaría mejor mediante la observación en un entorno auténtico utilizando una rúbrica que defina claramente las expectativas de comunicación. Sin embargo, un objetivo en el ámbito cognitivo como «Los estudiantes identificarán las funciones de los ventrículos del cerebro» se evaluaría mejor utilizando elementos objetivos como preguntas de respuesta corta o preguntas de opción múltiple.

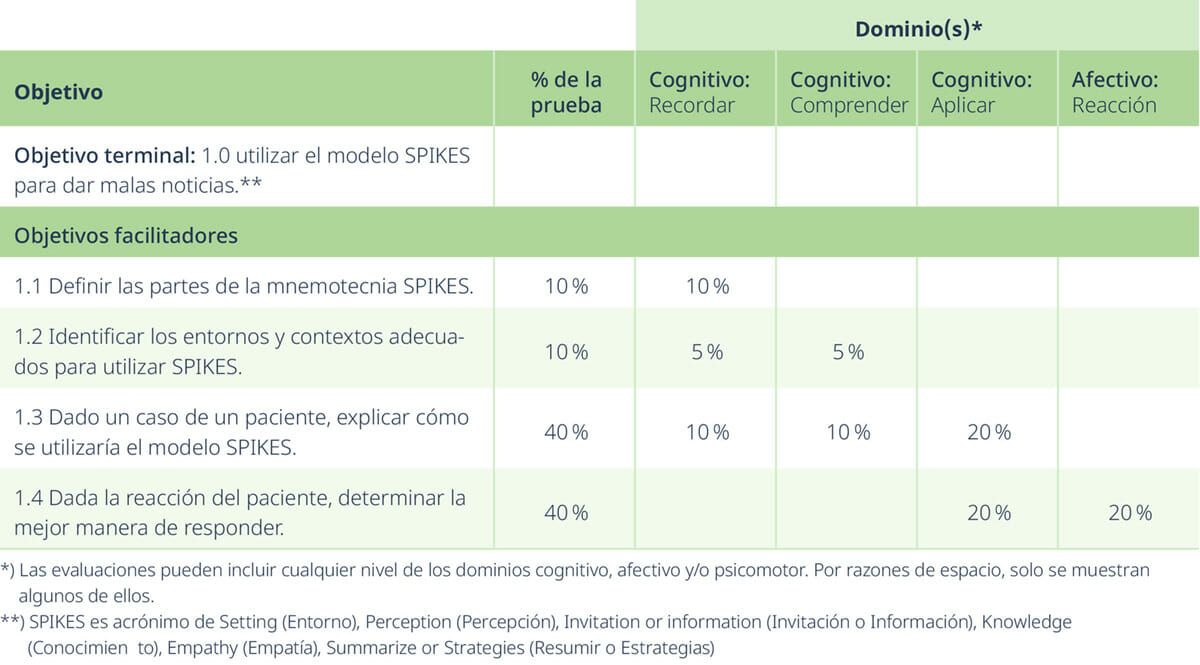

Una vez establecidos los objetivos, se puede elaborar un modelo de examinación para garantizar la cobertura y la adecuación de la evaluación a los objetivos (7). Por ejemplo, si se dice a los estudiantes que un examen cubrirá los objetivos de aprendizaje de los capítulos 1 a 3, pero solo se formulan preguntas del capítulo 2, la prueba tiene una cobertura deficiente. Si aparecen preguntas del capítulo 4, la prueba tiene una alineación deficiente. El material no puede evaluarse por igual, sino que debe reflejar la cantidad de tiempo dedicado a la enseñanza, que corresponde a la importancia relativa del tema (7). Los modelos de examinación pueden indicar los objetivos, los dominios de aprendizaje y el peso del tema en un examen (número de preguntas, valor en puntos o porcentaje).

Tabla 1: Ejemplo de modelo de examinación

Un modelo de examinación puede ayudar a los educadores a integrar la tecnología mediante el uso de bancos de pruebas o funciones del sistema de gestión del aprendizaje (LMS, por sus siglas en inglés) que permiten a los educadores crear evaluaciones eligiendo temas de las categorías que se alinean con los objetivos de aprendizaje. Las preguntas del banco de pruebas pueden elegirse de forma rápida y eficiente de entre las categorías apropiadas con valores puntuales que se reflejan en el modelo de examinación. Para ayudar a garantizar la integridad académica, algunos bancos de pruebas variarán automáticamente las preguntas, mientras que otras plataformas como Canvas LMS dan opciones para variar las preguntas permitiendo grupos de preguntas que eligen de un conjunto de preguntas disponibles, por ejemplo, «seleccionar 5 de 12». El instructor puede establecer estos grupos de preguntas para que se alineen con los objetivos y permitir que el sistema de gestión del aprendizaje o el banco de pruebas elija un conjunto único de preguntas alineadas para cada estudiante. La selección de un banco de pruebas o de un grupo de preguntas también puede ayudar a garantizar la integridad del examen al permitir que se realicen simultáneamente exámenes diferentes pero efectivamente equivalentes entre los estudiantes de la misma clase, lo que minimiza la posibilidad de que se produzcan incorrecciones en el examen, especialmente cuando los estudiantes son examinados desde lugares remotos.

Validez y Fiabilidad

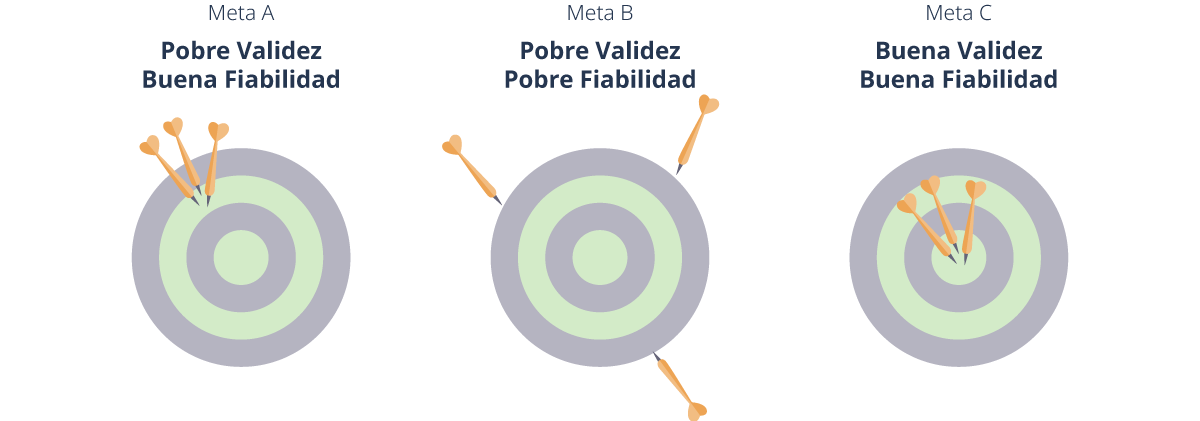

La validez y la fiabilidad son dos formas de evaluar las evaluaciones. La validez se refiere al grado en que la evaluación mide lo que pretende medir, mientras que la fiabilidad se refiere a la coherencia con la que una evaluación mide (5).

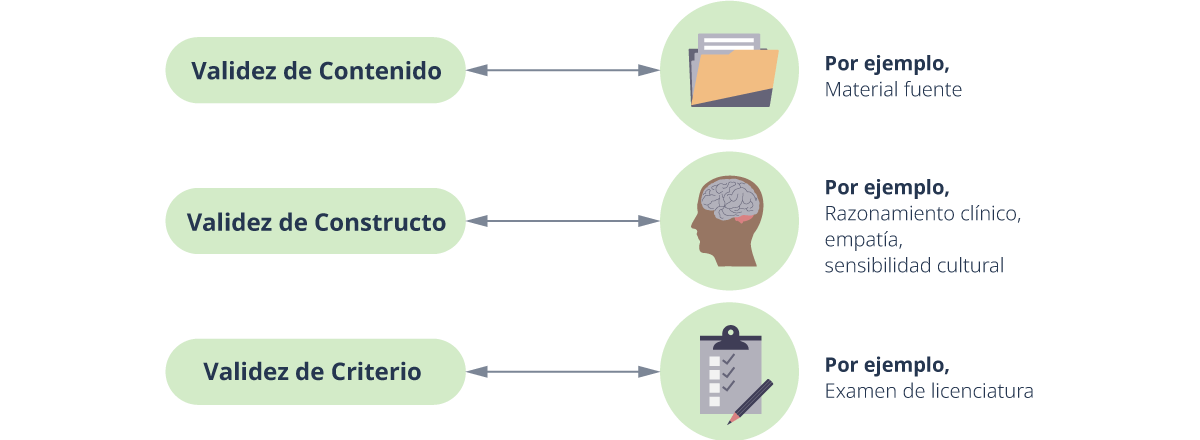

Por ejemplo, la validez de contenido analiza si una prueba mide el contenido previsto. ¿Un proyecto sobre los estados patológicos del riñón mide con precisión los conocimientos del estudiante sobre el riñón o algo más, como sus conocimientos de informática (3)? Los modelos de examinación refuerzan la validez de contenido al garantizar que los ítems de la prueba se ajusten a los objetivos.

La validez de criterio determina si la evaluación se correlaciona con un criterio externo. Puede ser concurrente, es decir, si el examen se correlaciona bien con otro examen como el USMLE o el NCLEX, o predictiva, es decir, si el rendimiento en este examen se correlaciona con el comportamiento futuro, como el rendimiento en un entorno clínico.

La validez de constructo determina si una evaluación mide un determinado constructo (por ejemplo, el rendimiento o el razonamiento clínico) según una justificación o teoría.

Algunos argumentan que la validez de contenido es el tipo de validez más importante para medir el rendimiento académico (7), mientras que otros afirman que la validez de constructo es el tipo de validez principal y unificador (9,10).

Validez de contenido, de constructo y de criterio con ejemplos.

La fiabilidad se refiere a la consistencia de una prueba para obtener los mismos o casi los mismos resultados en múltiples administraciones, asumiendo que el rasgo no ha cambiado (5). Por ejemplo, cabe esperar que un estudiante obtenga puntuaciones similares en un examen idéntico realizado con dos días de diferencia, suponiendo que todas las demás condiciones sean las mismas. La fiabilidad puede mejorarse mediante el uso de evaluaciones objetivas (por ejemplo, preguntas de opción múltiple) y, en el caso de las evaluaciones subjetivas, el uso de rúbricas y múltiples personas calificadoras capacitadas puede aumentar la consistencia.

Fiabilidad y validez.

Evaluación de las Evaluaciones y la Instrucción

Las evaluaciones no solo proporcionan información sobre el rendimiento de los estudiantes, sino que el análisis de los resultados de la evaluación puede proporcionar información valiosa sobre la instrucción del curso y la propia evaluación. Aunque el cálculo de las estadísticas puede ser algo engorroso, la mayoría de los LMS y plataformas ofrecen algunas formas de análisis de los ítems, como la media, la dificultad del ítem, la discriminación del ítem y la fiabilidad. La dificultad del ítem es una medida del número de personas que han acertado un ítem. Por ejemplo, una puntuación de 0,65 significa que el 65% de los encuestados acertaron esa pregunta. Una puntuación más baja significa que menos estudiantes fueron capaces de responder correctamente a la pregunta. La discriminación del ítem es una medida de si las respuestas de los examinados en ese ítem reflejan su puntuación global, es decir, si los estudiantes con puntuaciones altas aciertan la pregunta mientras que los estudiantes con puntuaciones bajas no lo hacen. Las puntuaciones de discriminación de los ítems van de -1 a 1, donde los valores negativos indican una mala discriminación que realmente resta validez al test, mientras que los valores de 0,40 y superiores tienen una excelente discriminación (11). Los valores de fiabilidad, como el alfa de Cronbach (una medida de consistencia o fiabilidad), deberían ser idealmente superiores a 0,90 para las pruebas de alto nivel o de toma de decisiones, mientras que 0,70 y más pueden ser más aceptables y factibles para las evaluaciones formativas o de rendimiento (12).

Hay que tener cuidado al aplicar estas estadísticas a los resultados de una sola clase en una evaluación referida a criterios. Por ejemplo, un grupo con talento y con una instrucción efectiva puede obtener una puntuación consistente en comparación con un grupo más heterogéneo, pero la evaluación de estos resultados y la identificación de los extremos en las diferentes mediciones también pueden mostrar puntos de preocupación con la construcción de la prueba o la instrucción. Los ítems con una dificultad muy alta (cerca de 0) o muy baja (cerca de 1) deben examinarse para ver si la pregunta es demasiado fácil o defectuosa. Los ítems con una discriminación muy baja (<0,15) deben ser revisados y potencialmente eliminados. Si la revisión de los ítems no indica problemas aparentes en la redacción de las preguntas, pero siguen existiendo dudas sobre la dificultad o la discriminación, debe examinarse la instrucción para asegurarse de que la pregunta se ajusta a los objetivos y al contenido. Antes de la instrucción, una prueba previa puede proporcionar datos para examinar los ítems de la evaluación. La dificultad de los ítems debe ser alta (o al menos más alta) en el grupo de la prueba previa, y las respuestas de los estudiantes antes de la instrucción deben estar distribuidas equitativamente entre los distractores (11).

Implicaciones Prácticas en la Educación Médica

Una vez que los objetivos están claramente definidos y la alineación está garantizada con un modelo de examinación, el siguiente reto para los educadores es redactar la evaluación. Una evaluación bien redactada ayuda a aumentar la validez, ya que garantiza que se evalúa a los estudiantes por su conocimiento del contenido, y no por su capacidad (o incapacidad) para entender preguntas mal redactadas o tareas poco claras.

Mejores Prácticas por Tipo de Evaluación

Preguntas de Selección Múltiple

Las preguntas de opción múltiple, normalmente en forma de preguntas de una sola opción (SBO, por sus siglas en inglés), suelen ser preferidas por su capacidad de abarcar grandes cantidades de material en poco tiempo, junto con la facilidad de redacción y calificación. Las preguntas de opción múltiple también pueden integrarse con la tecnología y la calificación automática, lo que los convierte en una opción favorita para las evaluaciones formativas. Las preguntas de opción múltiple bien redactadas también pueden tener una alta fiabilidad, así como capacidad de diagnóstico. Si bien las preguntas de opción múltiple pueden utilizarse para evaluar el recuerdo simple, también pueden utilizarse para evaluar las habilidades de orden superior añadiendo escenarios ricos en contexto que incluyan casos clínicos o de laboratorio (13,14).

Algunos puntos clave en la redacción de las preguntas de opción múltiple:

- El enunciado base (la primera parte de la pregunta) debe explicar completamente el problema o la pregunta. El estudiante debe ser capaz de formular la respuesta correcta antes de ver las respuestas (5,15).

- Las respuestas deben coincidir gramaticalmente con el enunciado base, ser homogéneas (por ejemplo, ser todas enfermedades o ser todas pruebas) y ser lo más breves posible (5,15).

- Los distractores (respuestas incorrectas) deben ser factibles para una persona no informada, pero no deben ser discutiblemente correctos (5).

- Las opciones «todo lo anterior» y «nada de lo anterior» deben utilizarse con moderación (5).

- Deben evitarse las frases negativas, pero cuando se utilicen, el negativo (por ejemplo, «no») debe ir en negrita y/o en mayúsculas para que se note (5).

- Evite las afirmaciones extremas, como «siempre» o «nunca» (16).

- Las preguntas ricas en contexto y que incluyen información clínica ayudan a evaluar las habilidades de orden superior y la transferencia del aprendizaje (13,14,16).

- Al crear preguntas ricas en contexto, ponga toda la información clínica relevante en primer lugar y evite cualquier ambigüedad (16)

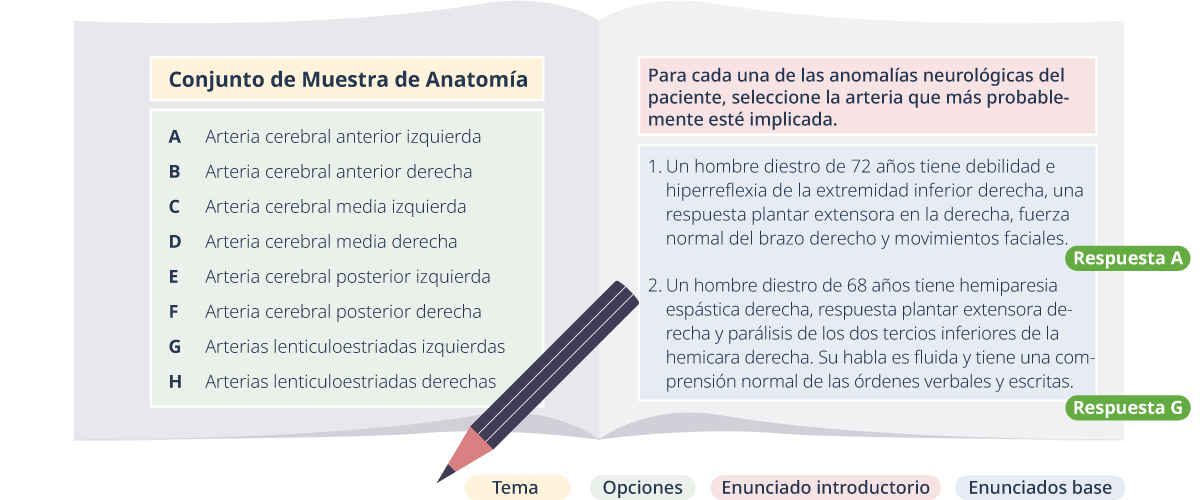

La mayoría de las preguntas de opción múltiple son preguntas del tipo de una sola opción, pero las preguntas de emparejamiento ampliado (EMQ, por sus siglas en inglés) pueden tener una sola opción o múltiples opciones de respuesta. Las preguntas de emparejamiento ampliado tienen muchas de las mismas características de las preguntas de opción múltiple, como contener opciones cortas homogéneas y un enunciado base largo completamente formado. Un formato utilizado por el National Board of Medical Examiners (NBME) incorpora viñetas de pacientes en la siguiente estructura:

- Tema

- Lista de opciones

- Enunciado introductorio

- Al menos dos enunciados base de ítems (puede ser de una sola opción u de opciones múltiples)

La lista de opciones es homogénea, con 5-20 elementos que se ajustan al tema. El enunciado base ofrece una breve descripción del tipo de paciente y de la situación (anatomía, enfermedad, prueba, etc.). El enunciado base del ítem da la descripción completa del paciente que el estudiante utilizará para responder al enunciado introductorio.

Modelo de preguntas de emparejamiento ampliado que muestra el tema, las opciones, el enunciado introductorio y los enunciados base.

Las preguntas de emparejamiento ampliado permiten realizar viñetas de pacientes, basar las preguntas en un contexto clínico auténtico y ofrecer más opciones, lo que puede ayudar a evitar el «tanteo», en el que los estudiantes pueden identificar la respuesta a partir de las opciones sin ser capaces de recordar la respuesta de forma independiente.

Tipos de Respuesta Abierta

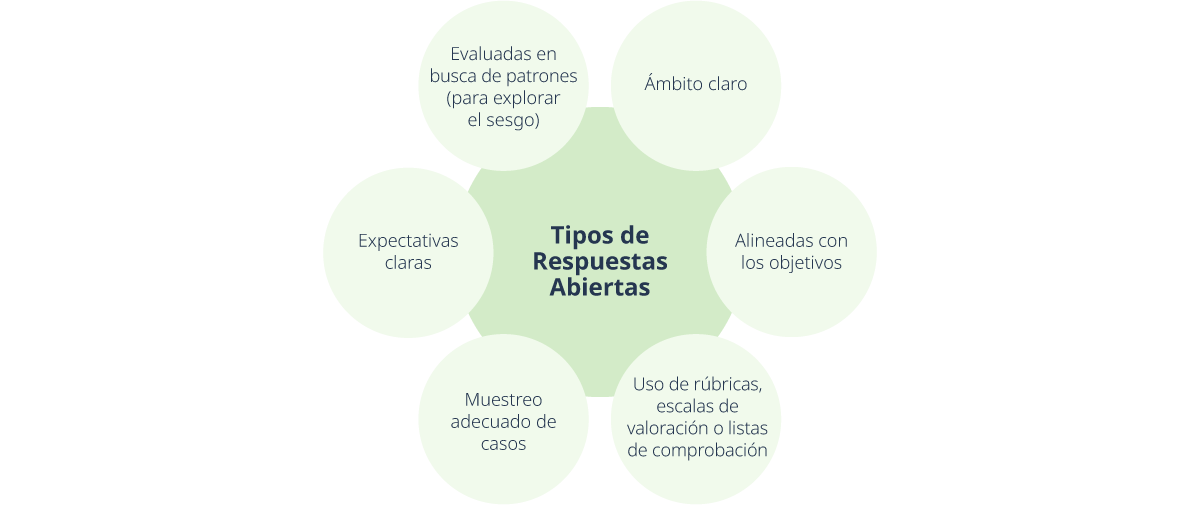

Mientras que las preguntas de tipo opción múltiple constituyen una gran parte de la evaluación para la educación sanitaria, otros tipos de evaluación son necesarios para determinar toda la gama de habilidades, conocimientos y disposiciones de los estudiantes. Las evaluaciones, como las preguntas abiertas, ensayos y exámenes orales, permiten a los examinadores evaluar la capacidad de los estudiantes para comunicar sus conocimientos de forma profesional, mostrar sus habilidades de razonamiento y toma de decisiones clínicas, y sintetizar e informar de forma efectiva sobre la información escrita. Las preocupaciones sobre la fiabilidad y la validez deben abordarse cuidadosamente con estos formatos.

Mejores prácticas en la aplicación de las preguntas de respuesta abierta

Mejores prácticas para las preguntas de respuesta abierta:

- Las preguntas deben formularse cuidadosamente para dejar claro al estudiante la profundidad y amplitud que se espera de su respuesta. Por ejemplo, en lugar de «Discutir las causas de la insuficiencia renal», que es amplio y vago, sea específico sobre lo que se espera, como «Comparar y contrastar 3 categorías de insuficiencia renal aguda, incluyendo los síntomas y las causas».

- Las preguntas deben estar alineadas con los objetivos para garantizar la validez del contenido (por ejemplo, discutir, comparar, sintetizar). En el caso de las evaluaciones sumativas o de todo el programa, donde los objetivos del curso pueden no ser aplicables, los criterios deben ser establecidos por un panel de expertos basados en la práctica profesional (17).

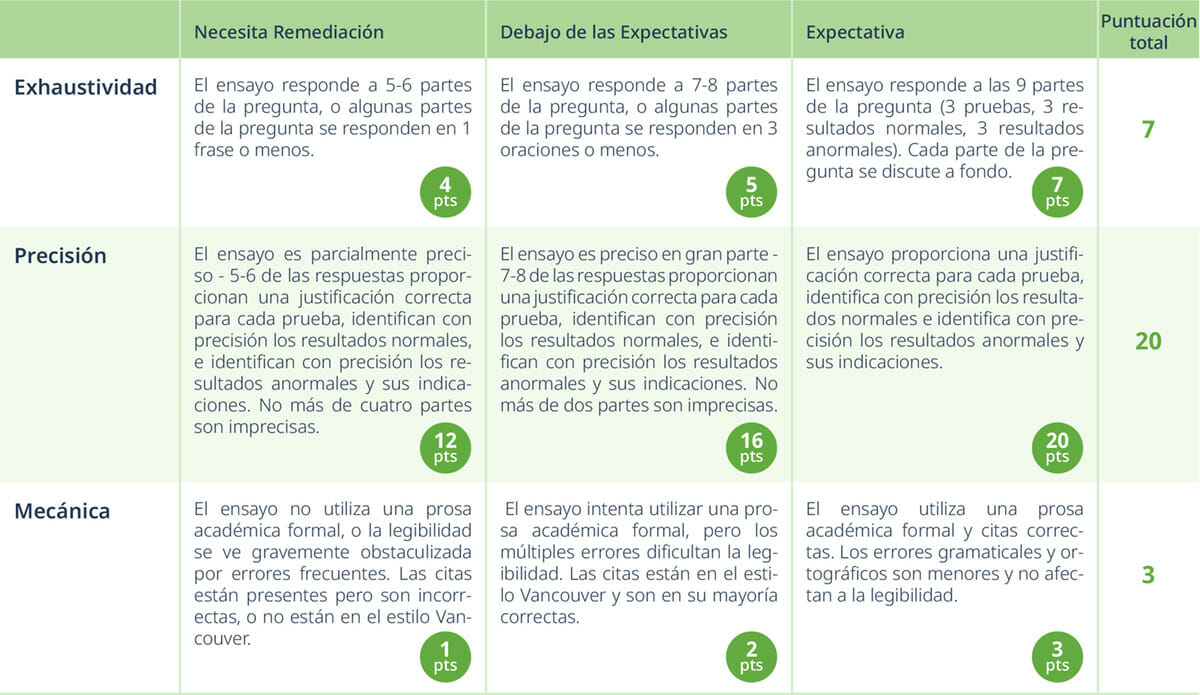

- Deben elaborarse rúbricas, escalas de calificación o listas de verificación (Apéndice) para garantizar la coherencia de la calificación y reducir el sesgo (5,17). Cuando se utilicen múltiples calificadores, estos deben ser entrenados para lograr la consistencia entre calificadores y grupos (17).

- En el caso de las evaluaciones orales, debe utilizarse un muestreo adecuado de casos para garantizar una profundidad y amplitud suficientes.

- Si se van a evaluar las habilidades escritas u orales, las expectativas deben quedar claras para el estudiante antes de la evaluación. Si el examen es escrito u oral pero evalúa el contenido y no las habilidades de presentación, se debe tener cuidado de centrar los criterios de evaluación en ese contenido y no en las habilidades lingüísticas o de escritura del alumno. Las destrezas adicionales, cuando se esperan explícitamente, solo deben evaluarse en la medida necesaria para la práctica profesional (17).

- Una vez concluidas las evaluaciones, los ítems de los exámenes deben examinarse en busca de patrones en las calificaciones de los examinadores y de variaciones en las puntuaciones por subgrupos para explorar posibles sesgos (17).

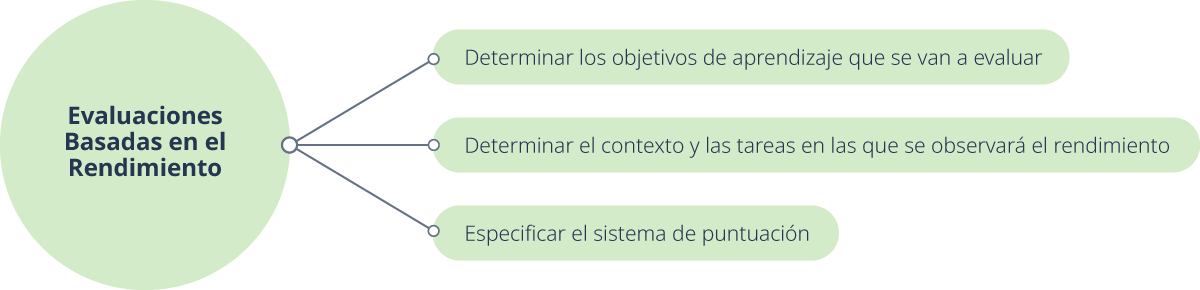

Evaluaciones Basadas en el Rendimiento

Las evaluaciones basadas en el rendimiento pueden darse en forma de simulaciones (incluyendo pacientes estandarizados), observaciones clínicas, mini ejercicios de evaluación clínica (mCEX) o evaluaciones clínicas objetivas estructuradas (ECOEs). Las evaluaciones de rendimiento permiten evaluar la competencia clínica mediante la observación de las habilidades y comportamientos en niveles variables de autenticidad. Las evaluaciones basadas en el rendimiento son un medio poderoso para evaluar distintas habilidades a través de todos los tres dominios del aprendizaje – cognitivo, afectivo y psicomotor.

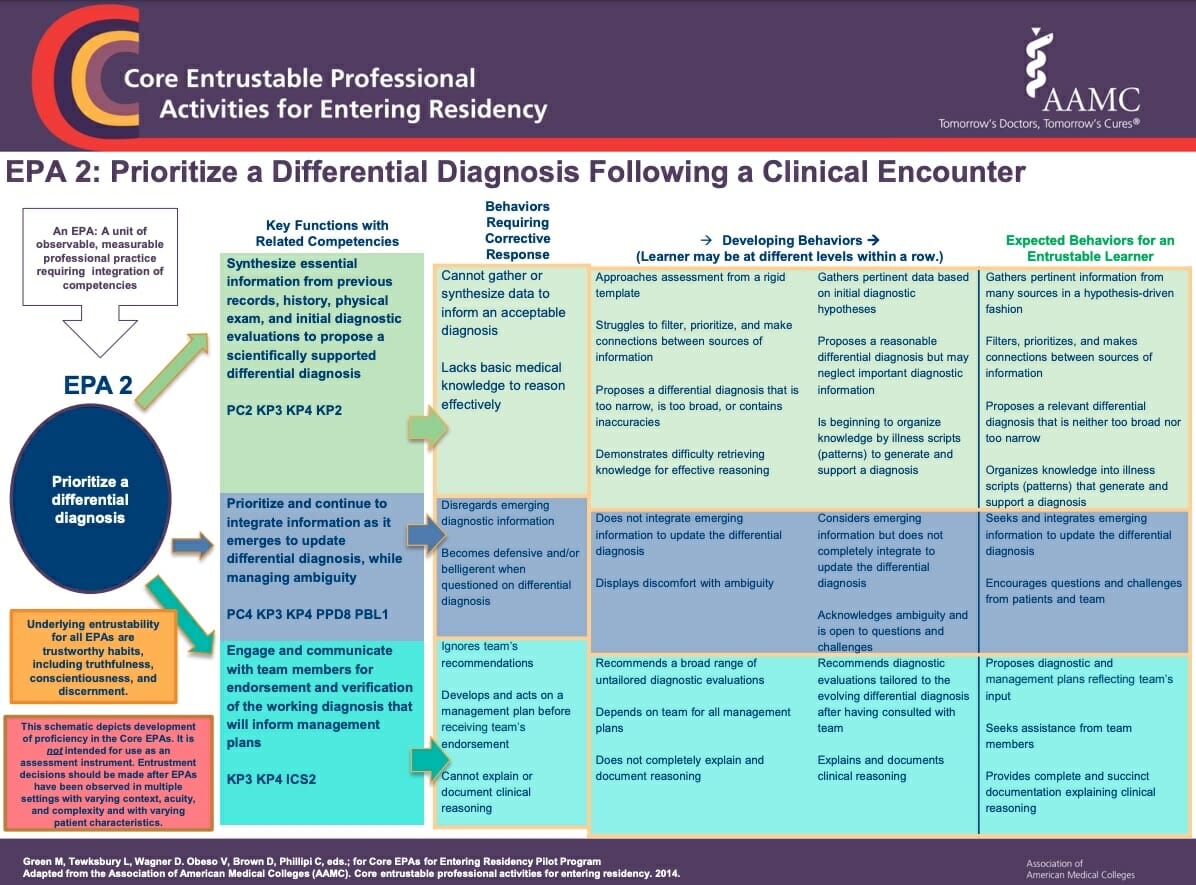

Para profundizar el desarrollo y evaluación de habilidades basadas en el rendimiento, la Association of American Medical College (AAMC) ha desarrollado guías para Actividades Profesionales Encomendables (APEs) “que incluyen 13 actividades que todos los estudiantes de medicina deberían ser capaces de realizar al entrar a la residencia” (18). Estas pueden ser usadas para desarrollar objetivos basados en competencias y para guiar evaluaciones clínicas efectivas. Para más información sobre las APEs, el manual completo y acortado de APE se encuentra en el sitio web de la AAMC, y una guía práctica “Twelve Tips” para orientar uso e implementación puede encontrarse en Medical Teacher (19).

Para desarrollar evaluaciones basadas en el rendimiento:

- Determine qué objetivos de aprendizaje serán probados usando evaluaciones basadas en el rendimiento (5). Para el dominio cognitivo, ¿serán los estudiantes evaluados en base a habilidades relacionadas a adquirir información o habilidades relacionadas a organizar y aplicar información? Para los dominios afectivo y psicomotor, ¿qué evidencia observable será usada para determinar que los estudiantes han obtenido las habilidades, conocimientos y disposiciones deseados? Cree un modelo de examinación para asegurarse que los objetivos, contenidos y evaluaciones de rendimiento estén alineados (1).

- Determine los contextos y tareas en los que el rendimiento será observado (5). Algunas evaluaciones serán “capturas” de habilidades en un momento en particular, como el ECOE y el mCEX. Algunas evaluaciones cubrirán un período de tiempo como los portafolios y las evaluaciones 360º.

- Especifique el(los) sistema(s) de puntuación (5): rúbricas, listas de verificación y/o escalas de calificación (ver Apéndice). La información de múltiples evaluadores, especialmente de estar capacitados, aumenta la fiabilidad de las puntuaciones (1). El uso de rúbricas y guías existentes pueden incrementar la validez de constructo y la validez de criterio, por ejemplo, el uso del manual de Actividades Profesionales Encomendables (APEs), las listas de verificación de ECOE, y/o los formatos de evaluación mCEX.

Evaluaciones basadas en el rendimiento

Recomendaciones

Perspectiva del Instructor

Explote el poder de la tecnología. Las preguntas de opción múltiple y las preguntas de emparejamiento ampliado pueden preguntarse en pruebas en línea donde se auto-califican para brindar retroalimentación inmediata a los estudiantes. Estructurar estos exámenes para que sean espaciados y entrelazados a través del periodo puede brindar beneficios adicionales para un mayor aprendizaje, retención y metacognición en los estudiantes (3). Usar la tecnología permite retroalimentación más frecuente sin añadir carga innecesaria a los educadores para calificar o usar valioso tiempo de clase.

Utilice múltiples tipos de evaluaciones para tanto las evaluaciones formativas como sumativas. Cada tipo de evaluación tiene fortalezas y debilidades. Mediante el uso de múltiples tipos de evaluaciones formativas, se provee a los estudiantes diversa retroalimentación sobre su rendimiento y progreso. Mediante el uso de múltiples tipos de evaluación en evaluaciones sumativas de alta exigencia, se pueden mitigar potenciales problemas de validez y fiabilidad que pueden encontrarse en un solo formato o instancia de evaluación, y permite un enfoque más holístico del progreso y de las habilidades de los estudiantes.

Utilice retroalimentación variada a través del tiempo, especialmente para las evaluaciones formativas. Mientras que la auto-evaluación y la revisión por pares a veces carece de fiabilidad, cuando se usan con rúbricas y listas de verificación para evaluación de baja o ninguna exigencia, estas pueden brindar valiosa retroalimentación a los estudiantes sobre su progreso. Similarmente, hay cierta evidencia en que la retroalimentación retrasada, brindada después del periodo de evaluación, podría ser más efectiva con estudiantes con más bajo rendimiento o con menos confianza (20). La retroalimentación frecuente a los estudiantes les permite dar seguimiento a su progreso e identificar áreas que necesitan remediación antes de que se dé cualquier evaluación de alta exigencia.

Analice la información proveniente de la retroalimentación formativa para brindar evaluación de la instrucción y del diseño del curso para ayudar a identificar las áreas que necesiten mejoría o revisión. Los estudiantes podrían necesitar de remediación inmediata para cumplir con los objetivos del curso, y los instructores deberían usar la retroalimentación como fuente de información para la potencial revisión de elementos inefectivos del curso para futuras ocasiones de instrucción. Cuando las evaluaciones se usan de una manera formativa antes de la clase, los resultados de estas evaluaciones pueden usarse para ayudar a los docentes a enfocar su tiempo de clase en las áreas más demandantes.

Perspectiva del Estudiante

- Utilice los objetivos para ayudarle a planear y priorizar su estudio.

- Busque en el sílabo información sobre el número y tipo(s) de evaluaciones planificadas. De no estar especificadas, consulte a su instructor.

- No solo estudie hechos: esté preparado para aplicar lo que sabe a casos clínicos, incluso para pruebas con preguntas de opción múltiple. Considere usar hábitos de estudio activo como crear organizadores gráficos, hacer mapas conceptuales y usar estudios de caso en vez de la relectura.

- Para exámenes de rendimiento, pregunte sobre la rúbrica, escalas de calificación, o lista de verificación que serán usadas, de estar disponibles. Si no están disponibles, busque en línea temas similares que podrían encontrarse en ECOEs o APEs.

Preguntas de Reflexión

(Seleccione todas las que correspondan.)

1. ¿Las evaluaciones pueden usarse para qué propósitos?

a. Para medir el aprendizaje que ha ocurrido

b. Para reforzar el aprendizaje

c. Para medir el progreso del estudiante

d. Para motivar a los estudiantes

2. ¿En qué maneras puede incrementarse la validez de contenido?

a. Comparando el contenido con un examen de licenciatura

b. Usando un modelo de examinación

c. Asegurando la alineación con los objetivos

d. Revisando ítems de prueba con muy baja discriminación o muy alta dificultad

3. ¿Cuáles son algunas “buenas prácticas” al redactar preguntas de opción múltiple?

a. Tener distractores factibles pero no discutiblemente correctos

b. Usar palabras fuertes como “siempre” y “nunca”.

c. Tener un enunciado claro y completo.

d. Usar casos clínicos cuando sea posible

4. Al revisar evaluaciones, ¿cuáles son algunos signos de alarma que los educadores deberían buscar?

a. Ítems que son muy fáciles o muy difíciles

b. Ítems con alta discriminación

c. Subgrupos (como raza, lengua o género) con igual rendimiento en los ítems

d. Evidencia de sesgos o inconsistencias entre evaluadores

(1) a,b,c,d. (2) b,c,d. (3) a,c,d. (4) a,d.

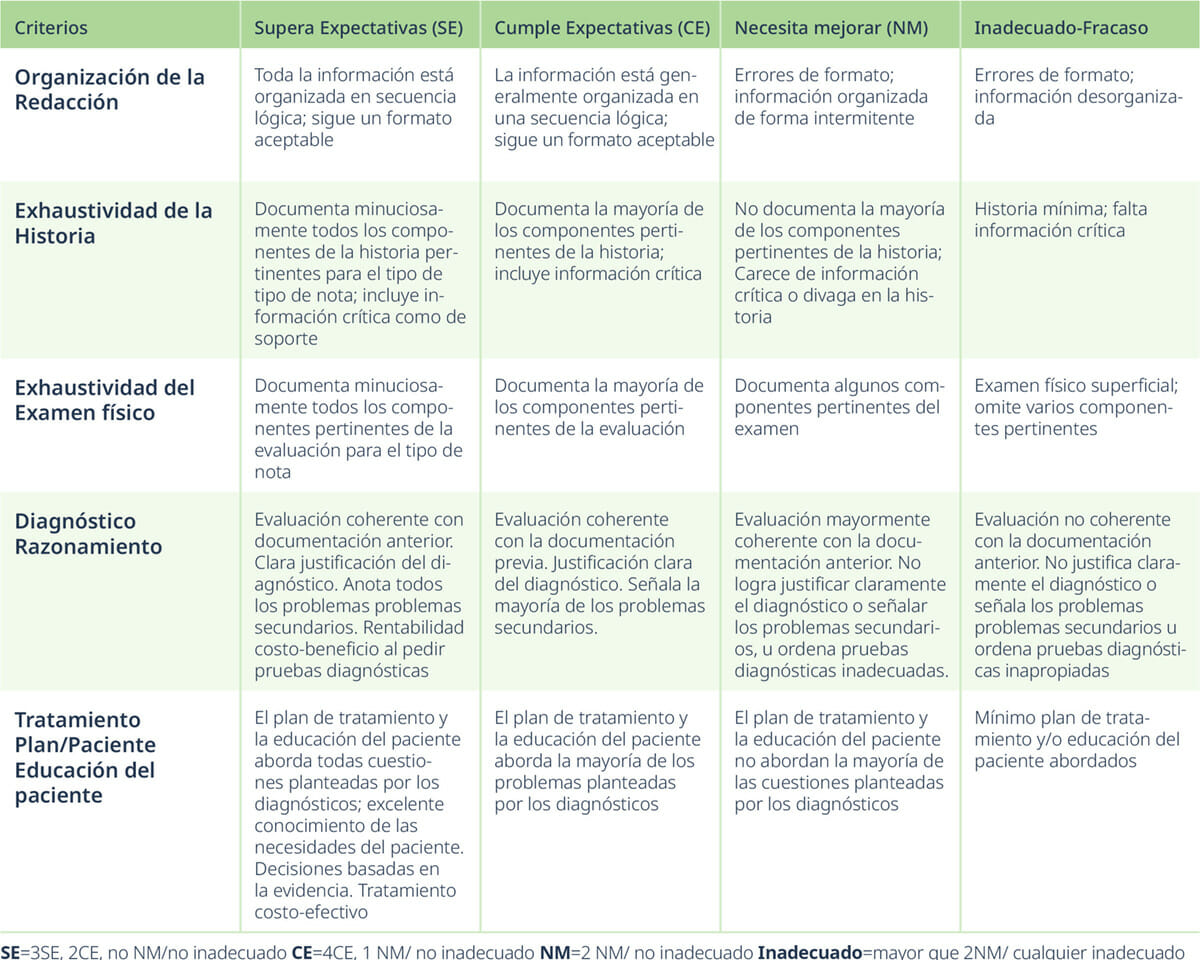

Apéndice

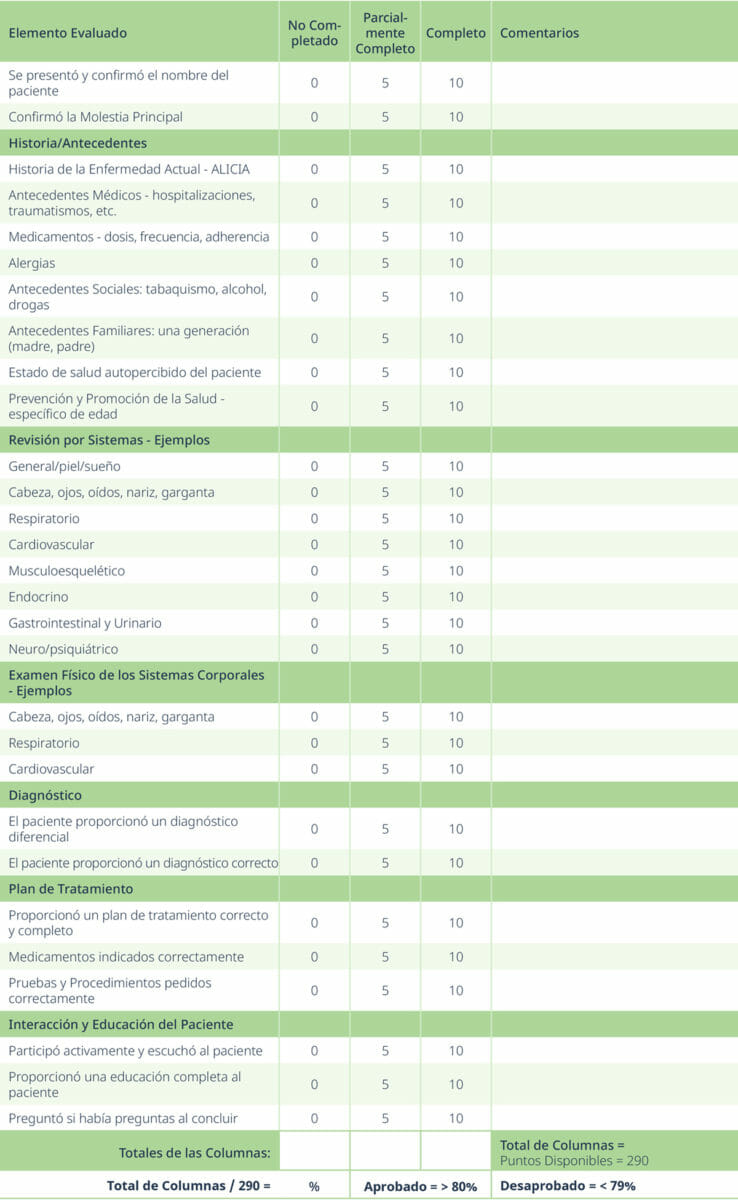

Rúbrica Clínica Modelo

Modificado del documento fuente de la Florida International University (21)

Rúbrica Modelo de Calificación de ECOE

Instructions: Circle the score for each row, add up the total points for each column, add all the column totals for the final score, divide by total possible number of points for overall percentage. Pass = 80% or greater.

Modificado del documento fuente de la University of Arizona College of Nursing (22)

Manual Modelo de APE

Página modelo del Manual de APE de la AAMC (18)